[2020]FUEL: Fast UAV Exploration using Incremental Frontier Structure and Hierarchical Planning¶

约 1183 个字 预计阅读时间 5 分钟

前置知识 ¶

PCA 降维 ¶

PCA(Principal Component Analysis)是机器学习中常用的一种降维算法,它通过计算样本的协方差矩阵来寻找主成分,并选择主成分个数来降低维度。

Tip

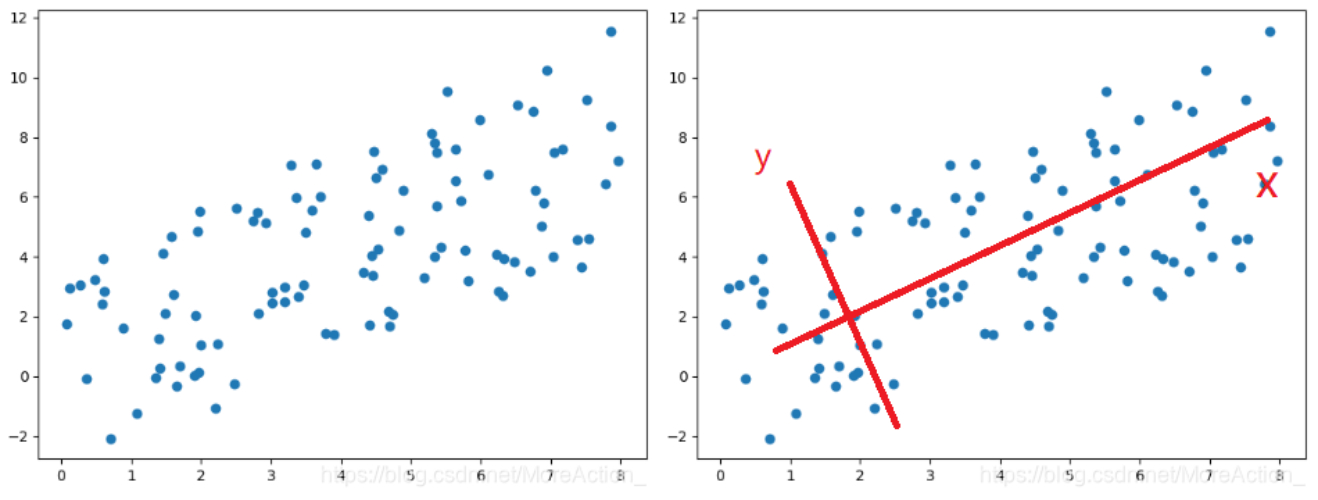

旋转原始坐标系得到图中新的坐标系(红色表示)

可以看到,数据在x轴上的变化大,而在y轴变化小,变化小意味着数据在这个特征上没有太大的差异,因此可以忽略Y轴的数据,实现降维

PCA其实做的就是这么一件事,求出了一个正交矩阵P,然后用这个矩阵对数据进行正交变换得到新的数据:$ X_p = PX $

原理

度量信息量大小的方式:数据在某个轴上的分散程度即方差

先在整个数据空间中找到一个坐标轴(方向

数学推导

方差是每个元素与变量均值差的平方和的均值,一维数据的方差计算公式为:

为了后续计算方便,我们先进行去中心化操作(使数据均值为 0

接下来,我们的目标就是在这个数据空间中找到一个方向,使得数据在这个方向上的投影的方差最大,假设这个方向为 \(w\),\(\|w\|_2 = 1\)(单位向量

其中,\(\frac{1}{m} \sum_{i=1}^{m} x_i x_i^T\) 就是样本的协方差矩阵,令它为 \(C\),那么我们的优化目标就是:

为了解这个约束优化问题,使用拉格朗日乘数法,构造拉格朗日函数 \(L\):

然后对每个分量求导,得到:

解得:

这表明 \(w\) 是矩阵 \(C\) 的特征向量。将 \(w\) 代入目标函数中,得到:

因此,要找的最大方差就是协方差矩阵的最大特征值,而此时的方向就是最大特征值所对应的特征向量。次大方向自然是第二大特征值对应的特征向量,依此类推,直到我们找出了 \(K\) 个特征向量,以这 \(K\) 个特征向量作为新的坐标系,然后将原始数据投影到这个坐标系下即可得到降维后的数据。

论文内容 ¶

增量前沿信息结构 ¶

1、前言信息结构 (FIS)

创建新的前沿集群 \(F_i\) 时,计算前沿信息结构 \(FI_i\),其包含的内容如下:

| Data | Explanation |

|---|---|

| \(C_i\) | 集群的所有单元格 |

| \(P_{avg,i}\) | \(C_i\) 的平均位置 |

| \(B_i\) | 集群的轴对齐边界框 |

| \(VP_i\) | 候选监测点 |

| \(L_{cost,i}\) | \(F_i\) 与所有其他集群的连接成本 |

2、增量前沿检测和聚类

作用:更新地图

步骤:记录更新区域 \(B_m\) 的 AABB,遍历所有簇,返回与 \(B_m\) 相交的所有簇,检查返回簇,删去不是边界的簇。通过区域增长算法搜索新的边界并聚类,若最大特征超过阈值,先利用 PCA 降维 ( 沿第一个主轴分为两个簇 )。

3、视点生成和成本更新